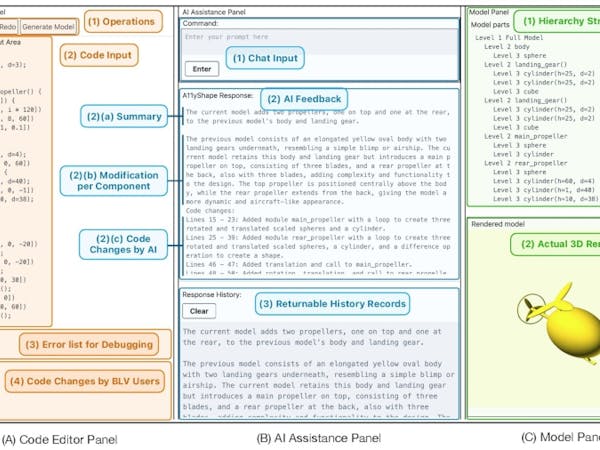

Naukowcy z Uniwersytetu Waszyngtońskiego, Uniwersytetu Purdue, Massachusetts Institute of Technology (MIT), Uniwersytetu Nauki i Technologii w Hongkongu, Uniwersytetu Stanforda, uniwersytetów w Waszyngtonie, Michigan i Teksasu w Dallas we współpracy z firmą NVIDIA opracowali system dla programistów z wadą wzroku umożliwiający tworzenie, edycję i weryfikację modeli 3D: A11yShape.

„Rzeczy (takie jak drukowanie 3D i prototypowanie obwodów) stanowią duże wyzwanie dla niewidomych użytkowników, zwłaszcza gdy robią to sami” – wyjaśnia Liang He, starszy autor pracy, którego inspiracją były zmagania się niewidomego kolegi z klasy z zadaniami modelowania 3D. „Za każdym razem, gdy pracował nad swoim zadaniem, musiał poprosić kogoś o pomoc i zweryfikowanie wyników. To pierwszy krok w kierunku zapewnienia osobom z wadą wzroku równego dostępu do kreatywnych narzędzi, w tym do modelowania 3D”.

System opiera się na modelu dużego języka (LLM) OpenAI GPT-4o i rozpoczyna się od przechwyconych obrazów modeli 3D generowanych przez użytkowników OpenSCAD — etap ten, ponieważ ma miejsce w przypadku tekstu, można obsłużyć za pomocą czytników ekranu, monitorów brajlowskich i innych istniejących technologii wspomagających. Następnie model dzieli modele na strumień tokenów i statystycznie wybiera tokeny kontynuacji, które są prezentowane użytkownikowi jako opis modelu oparty na najlepszych staraniach – umożliwiając iteracyjny rozwój bez pomocy osoby widzącej.

„Używał pierwszej wersji systemu i przekazał nam wiele naprawdę dobrych opinii, które pomogły nam ulepszyć system” – mówi o wkładzie swojego kolegi z klasy. „Następnym krokiem jest próba wsparcia tego procesu – przejścia od modelowania 3D do produkcji”.

Prace zespołu dostępne są w serwisie Materiały z 27. Międzynarodowej Konferencji ACM SIGACCESS na temat komputerów i dostępności (ASSETS ’25) na warunkach otwartego dostępu.